Les journaux sont une source brute d’informations accessible à tous les référents. Reste à savoir comment les affiner et les rendre lisibles.

Chaque fois qu'un robot ou un utilisateur passe sur les pages d'un site Web, il accumule des lignes de journaux. À partir de ces données conservées par l'hôte, il est possible de suivre le parcours d'analyse du moteur de recherche. Le parrain qui veut les consulter dispose de deux options: utiliser une solution de paye clé en main, qui met à disposition les données choisies, ou importer des journaux et analyser ce qu'il veut. Voici comment configurer rapidement cette deuxième solution.

Importez et présentez vos logs

Stockés par le serveur, les journaux ne sont pas directement accessibles. Sur un serveur partagé, tel que OVH ou 1 & 1, il suffit d’accéder à l’interface d’hébergement, de faire la demande au serveur et de télécharger les fichiers (un par jour) au format zip. Sur un serveur non partagé, Hafid Mermouri, CTO France chez Performics, rappelle qu’une fois connecté au serveur SSH, il est nécessaire de "récupérer dans le fichier de configuration du serveur Web (par exemple apache2) une ligne du type CustomLog / path / to / the / file / de / logs et suivez le chemin du fichier ".

Par défaut, apache2 est configuré pour utiliser le format de fichier "commun", mais Hafid Mermouri recommande le format "combiné", car "il ajoute des informations sur le référencement et l'agent-utilisateur, qui sont très importantes pour le référencement". Selon lui, répéter cette opération une fois par mois est suffisant pour la plupart des sites.

Une fois en possession de ses journaux, le SEO peut les intégrer sur Excel dans un tableau croisé dynamique ou sur DataStudio via un tableur de Google. "La première solution consiste à travailler sur ses données brutes, la seconde à obtenir des images facilement compréhensibles par les employés qui ne sont pas des spécialistes du référencement", explique le CTO Performics.

Organisez vos journaux pour la lecture

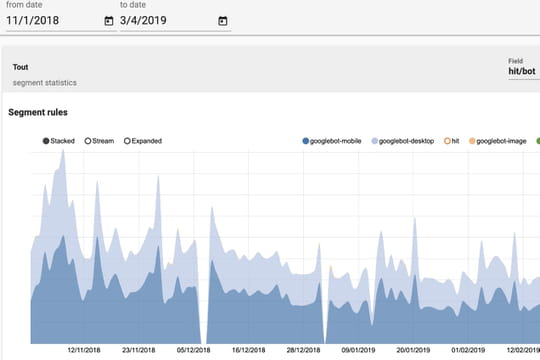

La sélection des journaux de Google est la première information de toute personne souhaitant mesurer l’exploration de son site par des robots des moteurs de recherche. Quentin Adt, fondateur du logiciel SaaS de suivi des journaux Kelogs, rappelle que "chaque bot est supposé avoir un agent utilisateur spécifique". Cependant, Google fabrique régulièrement plusieurs robots sur chaque site de son index. Et parmi eux, il y en a deux qui passent plus souvent et qui intéressent particulièrement le référencement: Googlebot mobile et Googlebot desktop, que Google donne à son agent-agent complet sur son site.

Googlebot Desktop:

● Mozilla / 5.0 (compatible; Googlebot / 2.1; + http: //www.google.com/bot.html)

● Mozilla / 5.0 AppleWebKit / 537.36 (KHTML, par exemple, Gecko, compatible;

Googlebot / 2.1; + http: //www.google.com/bot.html) Safari / 537.36

● Googlebot / 2.1 (+ http: //www.google.com/bot.html)

Googlebot Mobile:

● Mozilla / 5.0 (Linux, Android 6.0.1, Nexus 5X Build / MMB29P) AppleWebKit / 537.36

(KHTML, comme Gecko) Chrome / 41.0.2272.96 Mobile Safari / 537.36 (compatible;

Googlebot / 2.1; + Http: //www.google.com/bot.html)

Pour les isoler, Quentin Adt conseille de "filtrer les adresses IP commençant par 66.249 ou l'agent utilisateur contenant" Googlebot ".

"Recomposer l'arborescence du site dans Excel vous permet d'effectuer une analyse de répertoire"

Savoir que les robots passent sur son site est une chose, savoir que leur parcours dans l'arborescence du site en est une autre. D'où la nécessité de recomposer cet arbre sur Excel. Quentin Adt recommande de copier la colonne URL, de la coller après la dernière colonne pour la scinder en utilisant "/" comme séparateur. Vous devez encore nommer ces colonnes en fonction du type de pages présentes: les pages catégorie, sous-catégorie, produit, etc. "Dans le tableau croisé dynamique", conclut le fondateur de Kelogs, "cela permet une analyse d'annuaire".

Connaître la fréquence d'exploration de votre site par les bots de Google est une autre information utile, en particulier pour les marchands en ligne qui souhaitent vérifier que les pages de leurs produits sont souvent consultées assez souvent. Après avoir sélectionné les journaux Google, vous devez rendre la colonne de date plus lisible. Encore une fois, Quentin Adt recommande de placer la colonne de date en dernier et de la diviser sur le caractère ":", qui sépare la date des heures et des minutes moins utiles.

Au final, ces filtrages permettent des analyses fines. En croisant les URL par catégorie et en passant par les robots sur une période de quinze à trente jours, Hafid Mermouri peut apprendre que "lorsque googlebot parcourait mon site cent fois, il consacrait 10% de son temps aux produits, 20% aux catégories et 70% sur les doublons ou les pages de paramètres (ed : Généralement, les URL dupliquées incorporant des paramètres de suivi ou de tri sont incorporées. "Dans cet exemple, il constate que beaucoup de budget d’exploration est gaspillé.

Il est également possible de détecter un pic d’erreurs menaçant d’affecter la qualité de l’expérience client. Les données à observer sont le code d'état de l'erreur, la plus fréquente étant l'erreur 404. Pour s’assurer qu’il ne se propage pas de manière incontrôlée, Quentin Adt donne la direction suivante: "Dans la dynamique du graphe en croix, nous pouvons régler la date en abscisse et le code de statut en ordonnée, nous prendrons soin de supprimer 200 codes, afin de rendre les erreurs potentielles plus visibles ".